Visão Geral

O bloco Avaliador permite:Pontuar a qualidade do conteúdo: Usa IA para avaliar

conteúdo de acordo com métricas personalizadas com pontuações numéricas

Definir métricas personalizadas: Cria critérios de

avaliação específicos adaptados ao seu caso de uso

Automatizar o controle de qualidade: Constrói fluxos de

trabalho que avaliam e filtram conteúdo automaticamente

Como funciona

O bloco Avaliador processa conteúdo através de avaliação impulsionada por IA:Opções de configuração

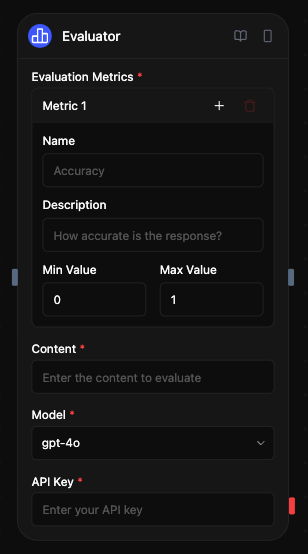

Métricas de avaliação

Defina métricas personalizadas para avaliar o conteúdo. Cada métrica inclui:- Nome: Um identificador curto para a métrica

- Descrição: Uma explicação detalhada do que a métrica mede

- Intervalo: O intervalo numérico para a pontuação (ex.: 1-5, 0-10)

Conteúdo

O conteúdo a avaliar. Isso pode ser:- Fornecido diretamente na configuração do bloco

- Conectado a partir da saída de outro bloco (tipicamente um bloco de Agente)

- Gerado dinamicamente durante a execução do fluxo de trabalho

Seleção de modelo

Escolha um modelo de IA para realizar a avaliação:- OpenAI: GPT-4o, o1, o3, o4-mini, gpt-4.1

- Anthropic: Claude 3.7 Sonnet

- Google: Gemini 2.5 Pro, Gemini 2.0 Flash

- Outros provedores: Groq, Cerebras, xAI, DeepSeek

- Modelos locais: Qualquer modelo executando no Ollama

Chave API

Sua chave API para o provedor de LLM selecionado. Esta é armazenada de forma segura e utilizada para autenticação.Como funciona

- O bloco Avaliador obtém o conteúdo fornecido e suas métricas personalizadas

- Gera um prompt especializado que instrui o LLM a avaliar o conteúdo

- O prompt inclui diretrizes claras sobre como pontuar cada métrica

- O LLM avalia o conteúdo e retorna pontuações numéricas para cada métrica

- O bloco Avaliador formata essas pontuações como saída estruturada para uso no seu fluxo de trabalho

Exemplos de casos de uso

Avaliação de qualidade de conteúdo

Cenário: Avaliar a qualidade de um artigo de blog antes de sua publicação

- O bloco de Agente gera o conteúdo do artigo

- O Avaliador avalia a precisão, legibilidade e engajamento

- O bloco de Condição verifica se as pontuações atendem aos limites mínimos

- Pontuações altas → Publicar, Pontuações baixas → Revisar e tentar novamente

Testes A/B de conteúdo

Cenário: Comparar múltiplas respostas geradas por IA

- O bloco paralelo gera múltiplas variações de resposta

- O avaliador pontua cada variação de acordo com clareza e relevância

- O bloco de função seleciona a resposta com maior pontuação

- O bloco de resposta retorna o melhor resultado

Controle de qualidade de atendimento ao cliente

Cenário: Garantir que as respostas de suporte atendam aos padrões de qualidade

- O agente de suporte gera uma resposta à consulta do cliente

- O avaliador pontua a utilidade, empatia e precisão

- As pontuações são registradas para treinamento e monitoramento de desempenho

- Pontuações baixas ativam um processo de revisão humana

Entradas e saídas

- Configuração

- Variáveis

- Resultados

- Conteúdo: O texto ou dados estruturados a avaliar

- Métricas de avaliação: Critérios personalizados com intervalos de pontuação

- Modelo: Modelo de IA para análise de avaliação

- Chave API: Autenticação para o provedor de LLM selecionado

Melhores práticas

- Usar descrições específicas de métricas: Defina claramente o que cada métrica mede para obter avaliações mais precisas

- Escolher intervalos apropriados: Selecione intervalos de pontuação que forneçam detalhes suficientes sem serem excessivamente complexos

- Conectar com blocos de agente: Use blocos avaliadores para avaliar as saídas de blocos de agente e criar loops de feedback

- Usar métricas consistentes: Para análises comparativas, mantenha métricas consistentes em avaliações similares

- Combinar múltiplas métricas: Use várias métricas para obter uma avaliação abrangente